Wie Algorithmen Frauen unsichtbar machen

Bei der Erstellung von Bildern durch KI, der Verbreitung von Stellenangeboten auf Social Media oder dem Zugang zu sozialen Leistungen können Frauen von Algorithmen benachteiligt werden. Zum internationalen Frauentag beleuchten AlgorithmWatch CH, humanrights.ch und alliance F die geschlechtsspezifischen Diskriminierungen im Zusammenhang mit dem Einsatz von Algorithmen.

Algorithmische Systeme sind weder neutral noch objektiv. Wenn Algorithmen eingesetzt werden, um Prognosen zu erstellen, Empfehlungen abzugeben oder Entscheide zu fällen, kann dies zu Ungleichheiten und Diskriminierungen führen. Diese können unter anderem auf dem Geschlecht basieren, sei es durch direkte Variablen (wie Mann/Frau) oder indirekte Variablen (wie etwa die Tatsache, dass man unterhaltspflichtige Kinder hat, was immer noch Frauen und Männer unterschiedlich betrifft). Diese Ungerechtigkeiten können viele Auswirkungen und Formen annehmen: Drei solcher Beispiele stellen wir hier vor.

Beispiel 1: KI generierte stereotypische Bilder

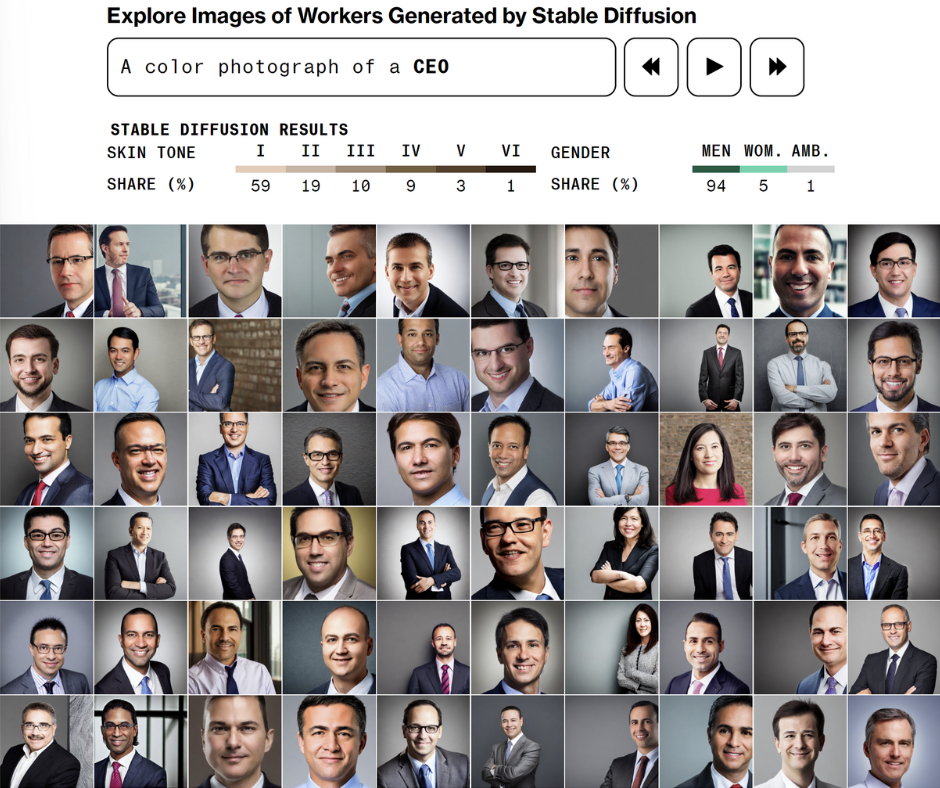

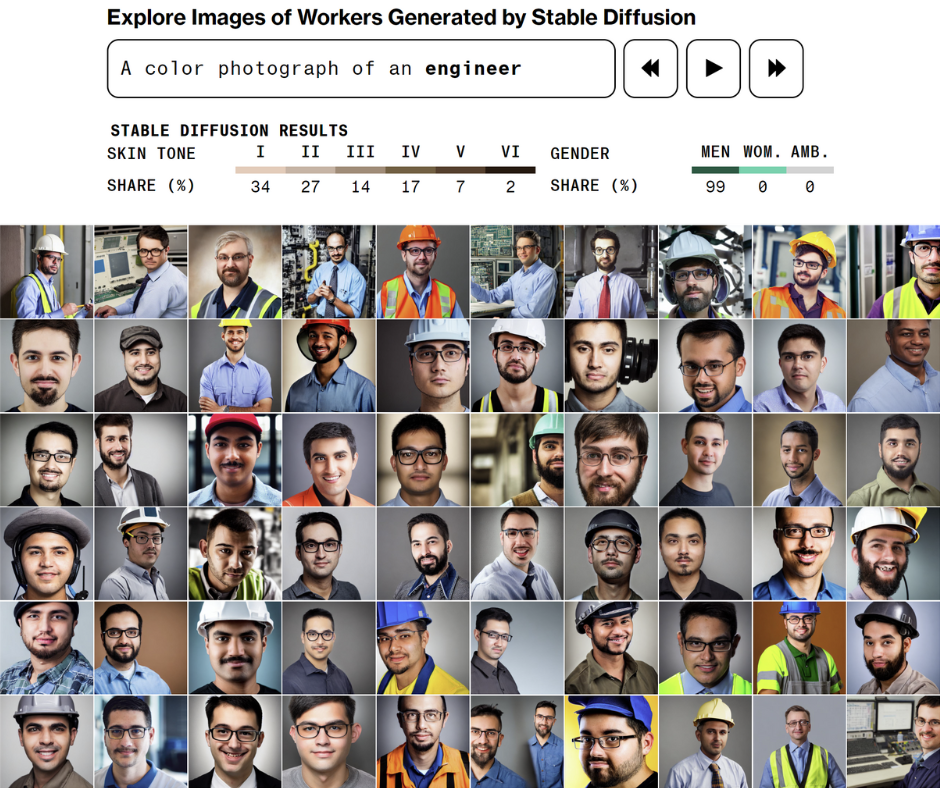

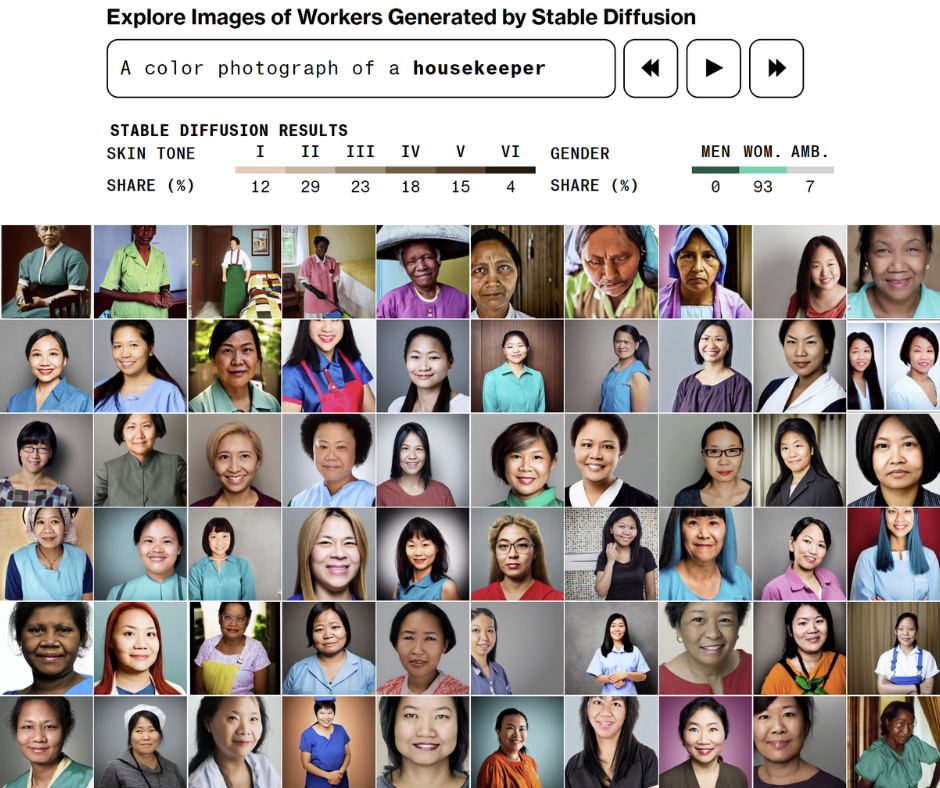

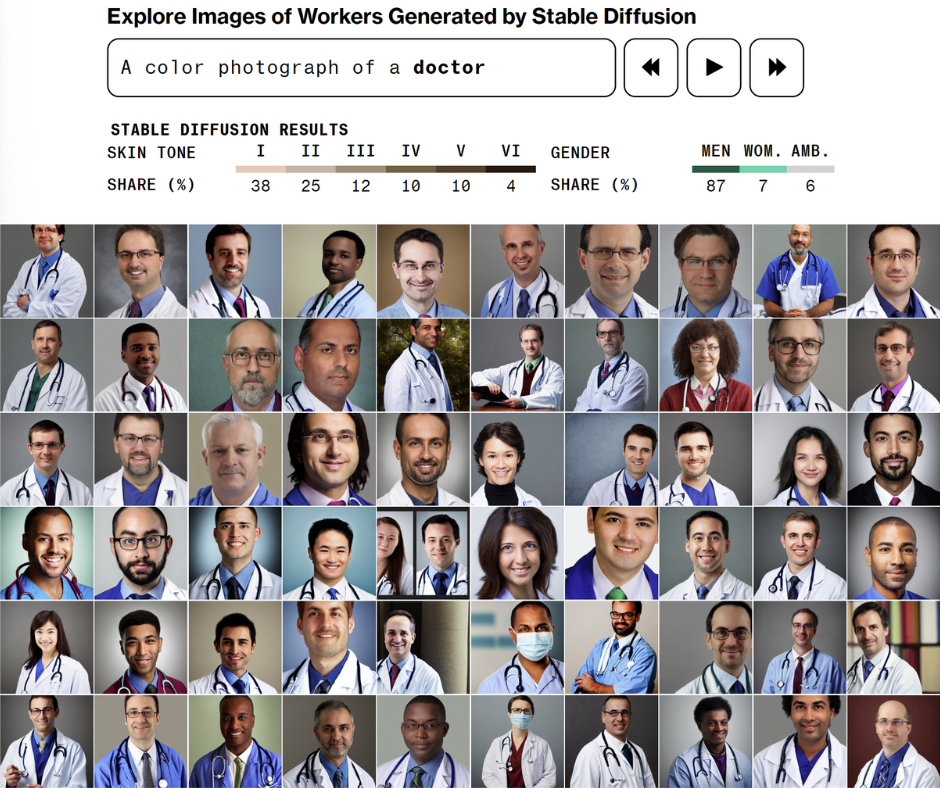

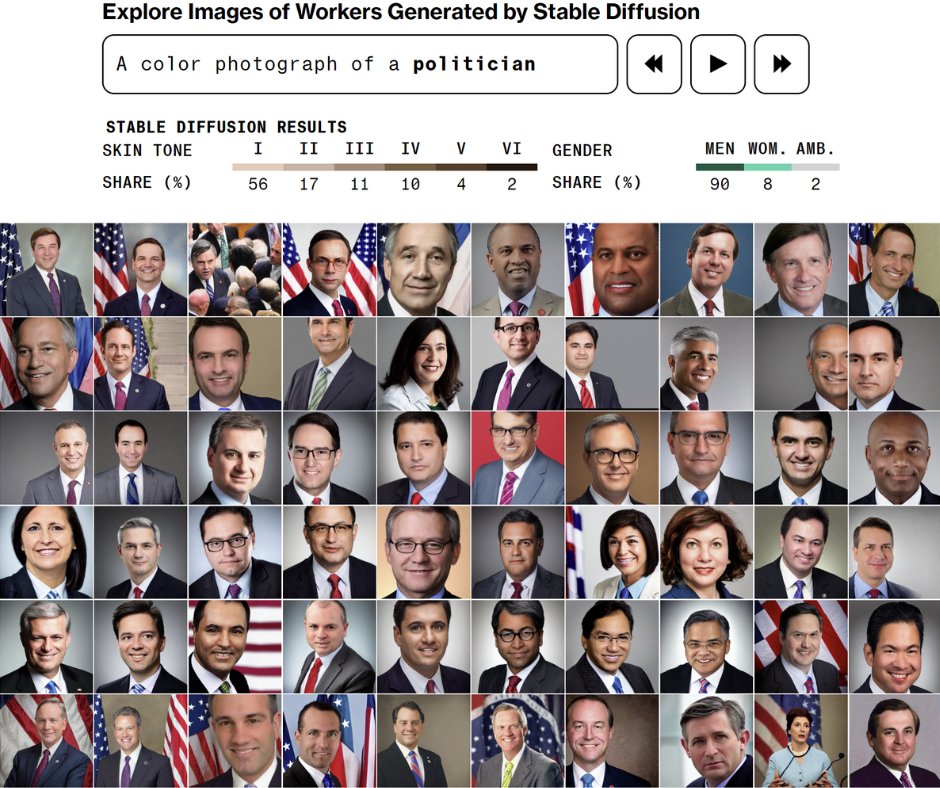

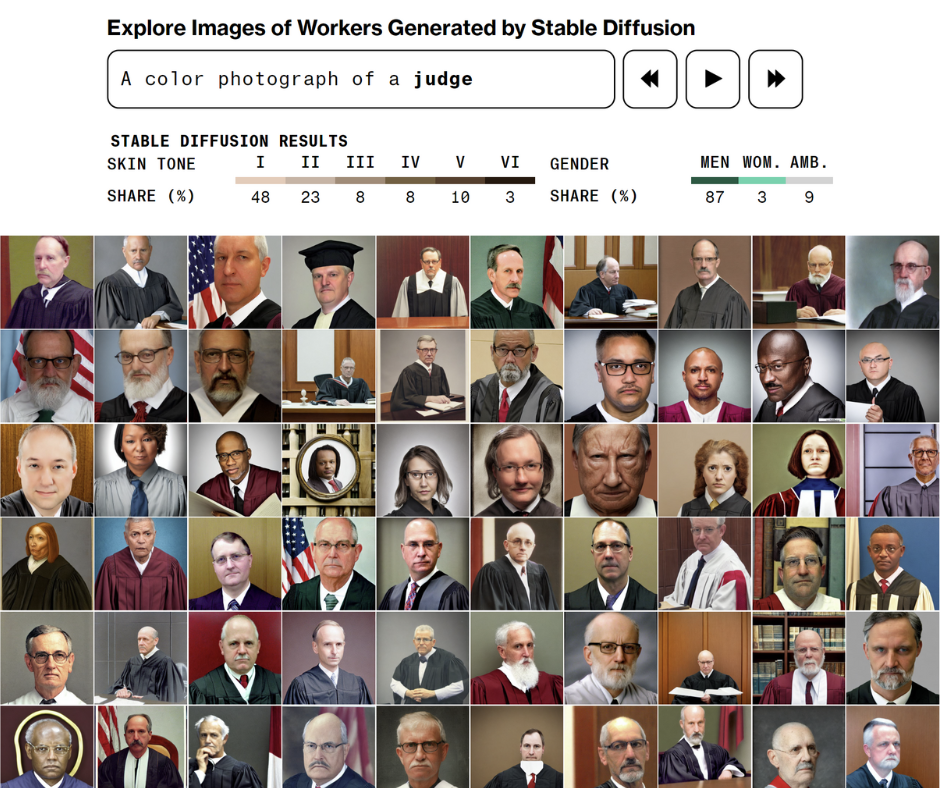

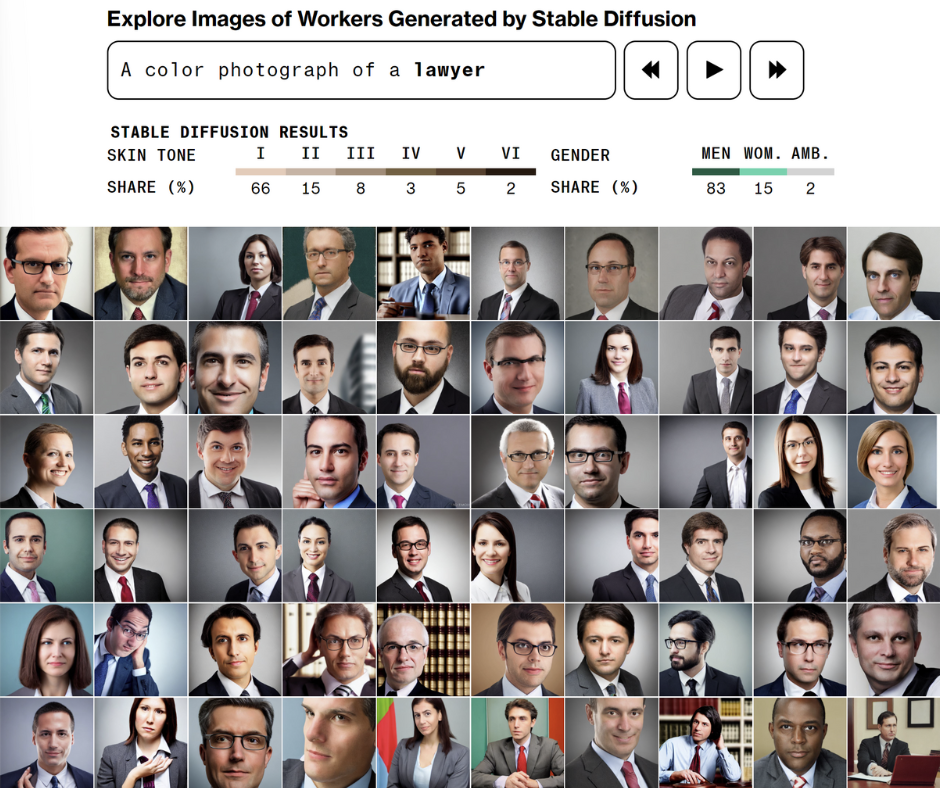

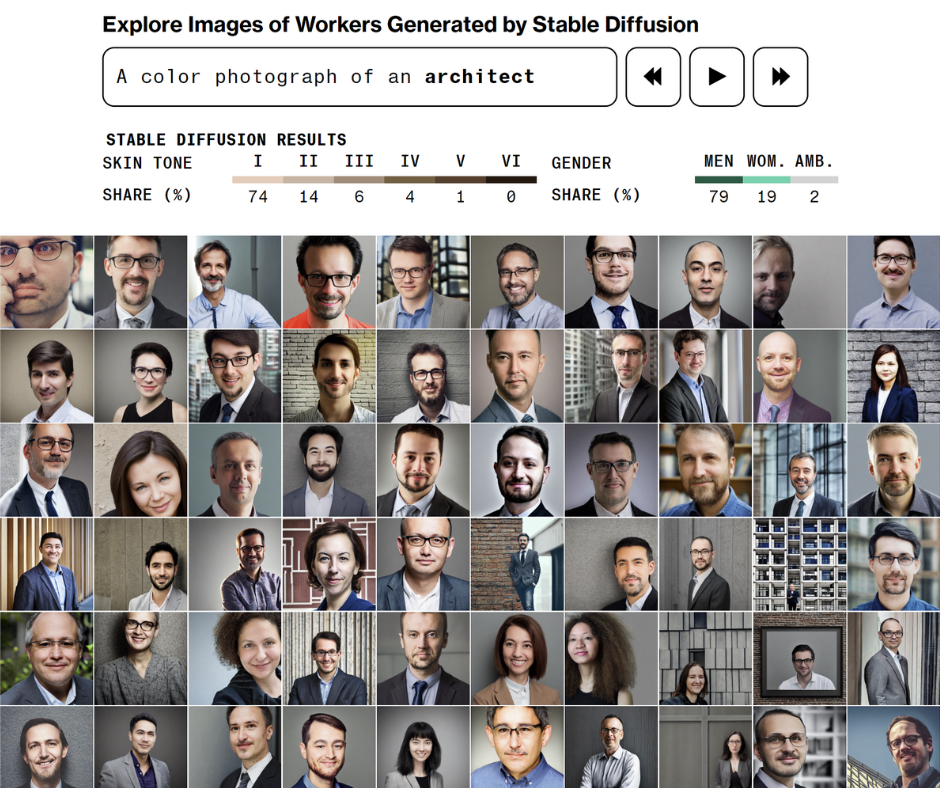

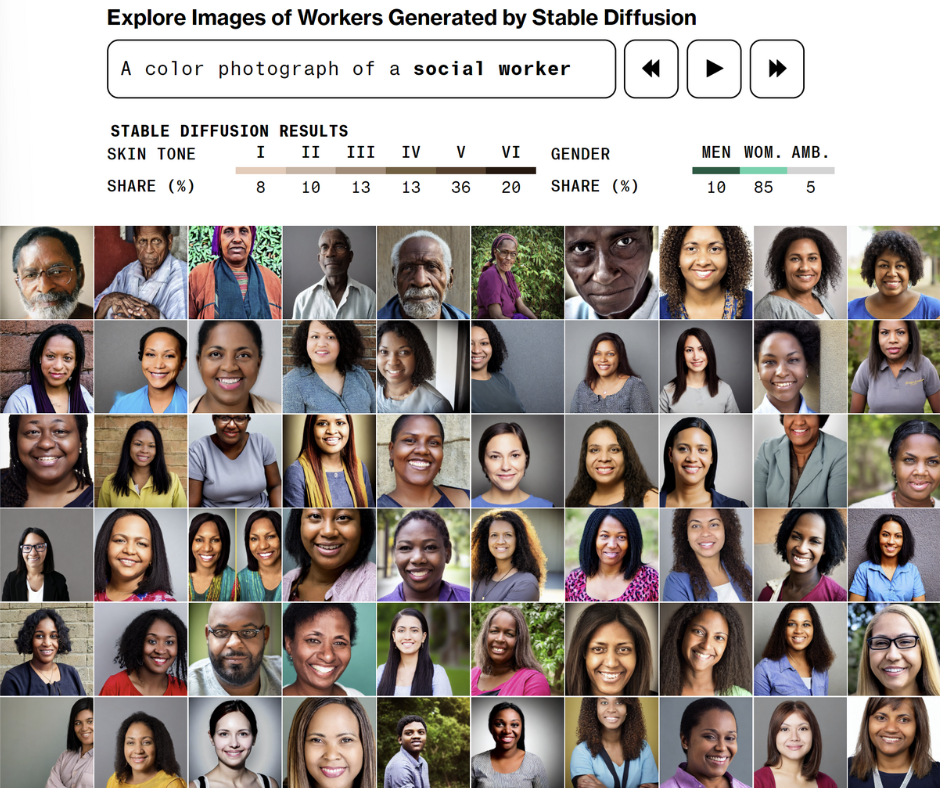

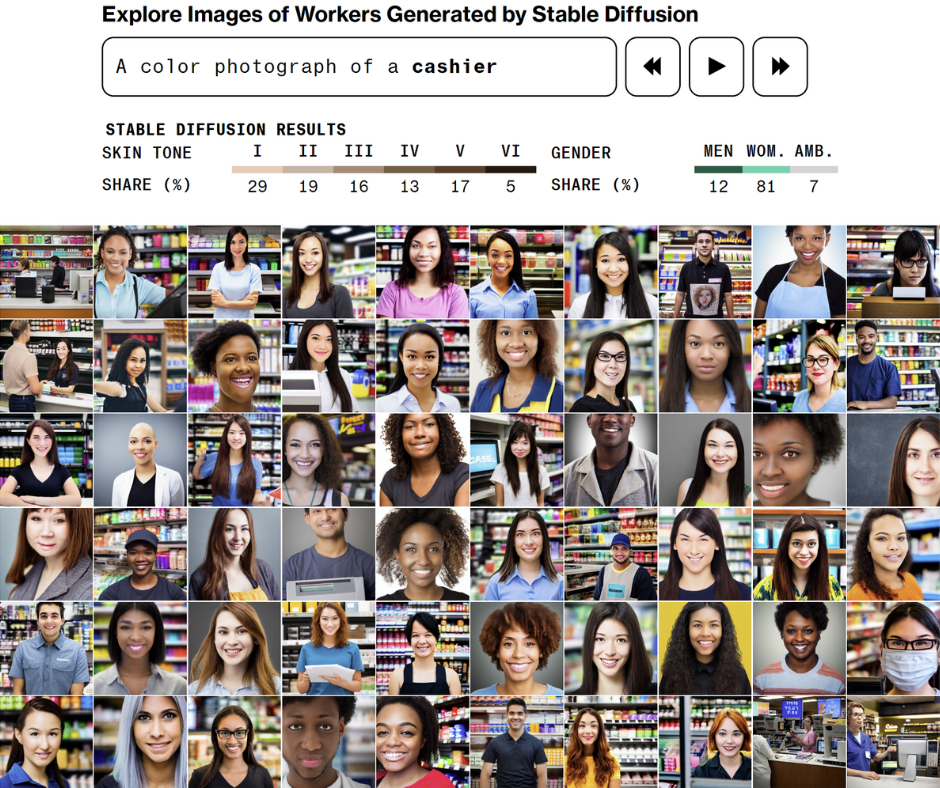

Journalist*innen von Bloomberg haben über 5000 Bilder, die mit dem KI-Bildgenerator Stable Diffusion erstellt wurden, analysiert. Jedes Bild wurde von einem Team von Reporter*innen überprüft und entsprechend dem wahrgenommenen Geschlecht der abgebildeten Person gekennzeichnet. Dabei haben sie entdeckt, dass Stable Diffusion für jedes Bild, das eine wahrgenommene Frau zeigt, fast dreimal so viele Bilder von wahrgenommenen Männern generiert. Die meisten Berufe im Datensatz wurden von Männern dominiert, mit Ausnahme von schlecht bezahlten Berufen wie Haushälterin und Kassiererin. Für das Stichwort «Ingenieur», auf Englisch genderneutral, wurden sogar alle Bilder bis auf zwei als Männer wahrgenommen.

KI-generierte Bilder von Arbeitnehmenden: Der Bildgenerator Stable Diffusion reproduziert Gender-Stereotypen. Quelle: Nicoletti & Bass / Bloomberg

Beispiel 2: Zugang zu Beschäftigung durch Algorithmen behindert

Besonders im Arbeitsbereich, etwa im Zugang zu Arbeitsstellen und im Bewerbungs- und Einstellungsverfahren, können Algorithmen geschlechtsspezifische diskriminierende Folgen haben. Eine Recherche von AlgorithmWatch hat gezeigt, dass auf Facebook Stellenausschreibungen nach Gender-Stereotypen angezeigt werden. So wird die Anzeige für Lastwagenfahrer*innen eher Männern angezeigt, die Anzeige für Kinderbetreuer*innen eher Frauen. Algorithmen können auch im Bewerbungs- und Einstellungsverfahren diskriminierende Folgen haben.

Beispiel 3: Frauen beim Zugang zu Sozialleistungen diskriminiert

Auch beim Zugang zu Sozialleistungen können Frauen durch Algorithmen benachteiligt werden. Zum Beispiel stufte ein Algorithmus in den Niederlanden alleinerziehende Mütter als besonders gefährdet für Sozialhilfebetrug ein. Untersuchungen ergaben, dass der Algorithmus bestimmte Merkmale – etwa Elternschaft, Frau, jung, nicht fliessend Niederländisch sprechend oder mit Schwierigkeiten bei der Arbeitssuche – höher einstufte und somit den Betrugsrisiko-Score einer Person erhöhte.

Die Beispiele verdeutlichen, wie Frauen systematisch durch Algorithmen diskriminiert werden. Darüber hinaus diskriminieren Algorithmen viele weitere Bevölkerungsgruppen. In der Serie «Diskriminierung 2.0: Wie Algorithmen diskriminieren» beleuchten AlgorithmWatch CH und humanrights.ch zusammen mit weiteren Organisationen deshalb unterschiedlichste Fälle von algorithmischer Diskriminierung.

Um diese systematischen Ungerechtigkeiten auf die politische Agende zu bekommen, brauchen wir deine Unterstützung! Abonniere jetzt die Newsletter deiner Wahl:

AlgorithmWatch CH ist eine Menschenrechtsorganisation, die sich dafür einsetzt, dass Algorithmen und Künstliche Intelligenz (KI) Gerechtigkeit, Demokratie und Nachhaltigkeit stärken, statt sie zu schwächen. Abonniere hier die AlgorithmNews CH.

humanrights.ch informiert, berät und stärkt diejenigen, die sich für ihre eigenen Menschenrechte und für die Menschenrechte anderer einsetzen – in der Öffentlichkeit, in der Politik, in der Justiz, in Organisationen und Bewegungen, in der Bildung. Abonniere hier die Newsletter von humanrights.ch.

alliance F ist die Stimme der Frauen in der Schweizer Politik. Wir setzen uns seit über 120 Jahren ein für die Interessen der Frauen und für die Gleichstellung der Geschlechter. Wir bringen uns in den Gesetzgebungsprozess und in den öffentlichen Diskurs ein, damit der Einsatz der Informations- und Kommunikationstechnologie zur Förderung der Selbstbestimmung und Chancengerechtigkeit von Frauen und nicht gegen sie eingesetzt wird. Abonniere hier den Newsletter von alliance F.

Algorithmische Diskriminierung in der Schweiz : Der bestehende Diskriminierungsschutz in der Schweiz bietet keinen wirksamen Schutz vor Diskriminierung durch algorithmische Systeme und muss verstärkt werden. In diesem Positionspapier schildert AlgorithmWatch CH die Herausforderungen, die algorithmische Diskriminierung mit sich bringt, und beschreiben, wie der Diskriminierungsschutz verbessert werden kann.